"Produire en Virtuel"

Dossier établi par François Reumont pour l’AFCEntretien avec Thomas Hardmeier, AFC

Pour la suite de L’Autre côté du périph, le réalisateur, Louis Leterrier, retrouve, dans Au-delà du périph, Omar Sy (qu’il a déjà dirigé dans la série "Lupin"). Toujours en tandem avec Laurent Lafitte, les deux policiers se lancent cette fois-ci sur les traces d’un meurtre entre Paris et Rhône-Alpes. C’est Thomas Hardmeier, AFC, qui signe l’image de ce film produit par Netflix, et dont les scènes de voiture sont actuellement tournées dans un studio équipé de dalles de LEDs.

Pourquoi avoir choisi de tourner sur des murs de LEDs ?

C’est principalement parce que le scénario comportait pas mal de séquences voitures, que ce soit des scènes de dialogues mais aussi des poursuites plutôt nerveuses et dangereuses... Face à la difficulté d’engager de telles séquences avec les comédiens tout en conservant un plan de travail réaliste, la solution tournage sur mur de LEDs s’est peu à peu imposée. Avec l’équipe de NeoSet, qui gère ce dispositif, on va tourner sur un plateau équipé d’un mur LED en demi-cercle de 11,5 m par 4,5 m. Les voitures de jeu étant montées sur système dynamique (vérins) pour simuler en synchronisme les mouvements.

D’où viennent les images projetées ?

On travaille à partir de pelures tournées par l’équipe de NeoSet, en parallèle des prises de vues extérieures principales en décor naturel. Lors des essais, plusieurs méthodes ont été testées et on a finalement choisi une prise de vues avec deux RED Monstro montées sur un rig avec des Fish Eyes Entaniya 220° qui couvrent les 360°. C’est vrai que c’est un rythme de travail à prendre. Après chaque plan important des voitures filmées de l’extérieur, l’équipe des VFX fait un passage avec son rig dans la lumière la plus proche des prises de vues réelles. Après assemblage numérique ("stiching") entre les deux caméras, on peut ensuite projeter la partie de l’image qui convient derrière ou devant les voitures en studio et on s’affranchit des incertitudes et des risques d’une voiture-travelling réelle.

Les images projetées déterminent tout pour la suite, n’est-ce pas ?

Oui. C’est l’un des enjeux principaux pour moi. Il faut que le rendu de la projo soit le plus juste possible, car après on a pas envie de se relancer dans de l’étalonnage par zone pour compenser telle ou telle dominante sur le fond ou les comédiens... Comme le rendu des dalles à LEDs est tout de même très brillant et lumineux dans les blancs, on est forcé de rééclairer les comédiens un minimum pour réduire le contraste. D’autant plus quand on a, comme nous, une séquence qui alterne successivement des tunnels et des extérieur jour plein soleil... Difficile de filmer uniquement avec la lumière générée par l’écran.

Et en assombrissant la projection de manière dynamique ?

En fait, diminuer la luminosité de l’écran provoque vite une sensation de blancs gris et des images un peu délavées... Pour faire face à cette contrainte, on a préparé deux versions d’étalonnage des pelures, une qui se rapproche du Log C et l’autre plus contraste, de manière à avoir une autre solution si le besoin s’en faisait sentir...

Avec quel matériel tournez-vous ? Avez-vous dû vous adapter pour le studio LEDs ?

On tourne avec des Alexas LF, souvent à deux caméras. Bien sûr, c’est la caméra principale pour laquelle la projection arrière est optimisée (parallaxe), la deuxième étant en longue focale , sur un gros plan, beaucoup plus facile à raccorder même si l’arrière-plan n’est pas parfait en point de vue. Pour les optiques, j’ai choisi de tourner principalement en anamorphique avec la série Cooke Anamorphic/i Full Frame Plus T2.3 Primes spécial Flair.

Mes focales sont les 32 mm, 40 mm, 50 mm, 75 mm, 85 mm Macro, 100 mm, 135 mm et 180 mm, qui couvrent toutes le plein capteur. Mais selon les besoins, d’autres optiques, dont des sphériques, nous servent aussi sur le film (cascades, caméra embarquées, moins de déformation que le Scope...). En tout cas, pour ce qui concerne les tests sur mur de LEDs, les Cooke fonctionnent plutôt bien, en les utilisant à pleine ouverture (f2.3), ce qui aide à garder l’affichage LED dans un flou plutôt bienvenu.

On dit que la mise au point sur le fond est la limite principale de l’écran LED actuellement.

Oui je confirme. À mon avis, ce n’est pas conseillé d’afficher suffisamment de profondeur de champ pour avoir le point sur l’écran. Le moiré est possible, et le plan devient inutilisable ou doit être retravaillé en postprod’. Ce qui est en revanche formidable, ce sont les reflets sur la voiture et pare-brise des images projetées sur le mur LED et qui donnent instantanément du réalisme. Et, comme en extérieur jour, j’utilise les filtres polarisants pour ajuster le dégré de réflexion sur les vitres. L’autre énorme avantage est aussi que toutes les positions et mouvements de caméra sont possibles sans complications et avec une rapidité de tournage impressionnante.

Seul petit bémol, la qualité des noirs de ces dalles, qui à mon goût n’est pas très profonde, surtout quand on passe à des séquences nocturnes. Seule solution : éviter à tout prix que la lumière sur les acteurs/voitures touche les écrans LED !

Vous avez également tourné le nouveau film de Jean-Pierre Jeunet à l’automne 2020. Avec le recul auriez-vous eu envie d’un tel dispositif ?

Le film de Jean-Pierre Jeunet a été entièrement tourné à Bry-sur-Marne dans un décor intérieur construit par Aline Bonetto donnant sur un très grand fond bleu pour la découverte pour incruster en postprod’ les maisons voisines et les arrière-plans d’une ville futuriste. Dans ce genre de situation (avec un fond incruste de près de 10 m de hauteur) la lumière vient toujours d’une direction un peu biaisée, les projecteurs étant obligatoirement installés toujours un peu trop haut par rapport à la découverte qu’on va ensuite générer à la place du fond incruste. Si on avait pu tourner avec un mur LED de cette taille – sans doute de la science-fiction ici en France, vu le coût d’installation ! – le décor virtuel aurait effectivement éclairé directement les comédiens. Ça aurait été sans doute génial, mais également plus contraignant car les découvertes et les ambiances lumineuses auraient dû être décidées bien en amont. Une nouvelle méthode très novatrice et créative de générer et d’intégrer un fond comme on le fait depuis longtemps avec des moyens plus simples comme des fonds peints ou Translight ou fond incruste. C’est en tout cas ce qui a été fait sur "Mandalorian", avec des univers complètement maîtrisés qui immergent littéralement les comédiens dans l’image, en perspective et en lumière.

Entretien avec Jérémie Tondowski, NeoSet

NeoSet est une société crée par Jérémie Tondowski, ex chef machiniste, et Alexandre Saudinos, ex stéréographe. Rejoints par DLP Paris pour la gestion des décors 3D et Street Co’ pour celle des murs de LEDs, ils ont installé leur studio à Ivry-sur-Seine, au cœur des studios Kremlin.

Parmi les productions en cours : Au-delà du périph, de Louis Leterrier, avec Omar Sy et Laurent Laffite, ou En roue libre, réalisé par Didier Barcelo, avec Marina Foïs.

Quelle est la genèse de NeoSet ?

L’idée de lancer une structure dédiée à la production virtuelle nous est venue pendant le confinement. Alexandre sortait d’un gros projet d’installation en réalité virtuelle pour un client institutionnel, et en découvrant la communication autour de la série "Disney Mandalorian", on s’est tous les deux dit que c’était exactement ça qu’on avait envie de faire... Le temps libre ne nous manquait pas, et on a pu en profiter pour travailler le projet, réunir les compétences et les fonds pour se lancer à l’été 2020. Depuis, nous avons déjà fait quelques plans pour des téléfilms (Balthazar avec Tomer Sisley, ou avec la prod’ Beaubourg Stories). Également des défilés de mode (Dior, décembre 2020) ou des événements pour de grandes entreprises (Peugeot). Actuellement, il y a deux films qui sont rentrés en tests, puis en production très récemment : Au-delà du périph, de Louis Leterrier (Mandarin Production pour Netflix) et En roue libre (The Film Production).

Notre credo, c’est de se mettre au service de chaque projet et de proposer le meilleur workflow qui ne soit pas une usine à gaz en fonction des demandes. Par exemple, sur Au-delà du périph, on a testé plusieurs solutions pour la prise de vues des pelures, dont celle qui semblait la plus qualitative (rig six caméras RED Komodo) mais on s’est finalement rabattu vers une solution plus légère en terme de tournage à base de deux RED Helium équipées de Fish Eye. Outre la quantité astronomique de données générée par six caméras 6K, on a également la lourdeur du processus de "stitching" entre chaque caméra qui peut vite devenir très compliqué quand les plans sont en mouvement, ces raccords entre images fonctionnant beaucoup mieux sur des plans fixes.

Pourquoi s’être installé à demeure ?

On a commencé par travailler avec un petit stock de LEDs qu’on déplaçait de décors en décors, mais rapidement on s’est aperçu que les frais d’installation et de remballage étaient vraiment très élevés en regard de la prestation. En réfléchissant avec des directeurs de prod’, l’option studio fixe s’est imposée car ça donne un côté plus simple dans la relation avec le client qui paye pour ce qu’il utilise. C’était la solution pour offrir ce genre de prestation à des tarifs concurrentiels, notamment face à un équivalent plus traditionnel en fond vert, avec effets réalisés après la prise de vues. On est parti sur du demi-cylindre pour notre mur de LEDs. Et un petit plafond qui sert essentiellement pour générer des reflets sur les pare-brise de voiture et éclairer les sujets. En tout 11,5 mètres de diamètre sur 4 m de hauteur

C’est suffisant ?

Au tout début, on se dit qu’il faut faire comme sur "Mandalorian" et construire un mur de 20 m de base... Mais dès qu’on fait des tests, on s’aperçoit que c’est bien l’écran qui fait le décor et pas l’inverse. A moins de tourner des plans très larges avec de la figuration, 75 % des besoins sont couverts avec une installation comme la nôtre... et même un peu plus petite en vérité. En outre, habiller un tel sol de décor de 250 m² va bien sur faire monter considérablement l’addition sur le plateau. Si on prend un des exemples en téléfilm, tout a été organisé en quelques jours pour remédier à la situation du Covid. Le réalisateur voulait un plan tourné sur les toits à Amsterdam mais sans aucune solution pour y déplacer l’équipe. On a envoyé une personne faire quelques photos sur place, puis assemblé en 3D un fond raccord pour filmer le comédien sur un petit bout de toit en décor et 40 m² de LEDs derrière. La séquence a pu être faite comme prévue, en quasi transparence.

Quelles dalles avez-vous choisies ?

Sur la question des dalles, là aussi on a fait preuve de pragmatisme. Il faut bien réfléchir au rapport qualité/prix, et la course au pitch le plus fin, à la dalle la plus moderne, n’est pas forcément justifiée. C’est un peu, selon moi, comme la course à la définition dans les caméras. On sait très bien que des images issues d’une Alexa en 3,2K est largement suffisante et constitue la majorité des images tournées au cinéma. Tout ça pour dire qu’après plusieurs séries de tests, on est parti sur des dalles en pitch 3,9, et un partenariat avec un fabricant de LEDs qui nous soutient. Colorimétriquement parlant, on en est très content. Le rendu de ces dalles a même été testé par Le Labo dans le cadre de la vérification de notre chaîne couleur pour le film de Louis Leterrier.

Justement, pouvez-vous m’expliquer le workflow prévu ?

Le workflow est le suivant : on tourne sur deux RED Helium en 8K les pelures avec objectif Fish Eye 220 °. Les éléments sont spatialement traités par nous pour être adaptés à la projection sur le cylindre que forment les dalles. Ensuite ils sont envoyés à l’équipe de Le Labo pour être étalonnés, puis reviennent chez nous en Log avec une couche d’étalonnage géré par fichier CDL. On charge ces clips dans nos machines, puis elles sont projetées en 10 bits en choisissant l’espace couleur de destination (Rec. 2020 pour de la HDR ou Rec. 709 pour du SDR). Il ne reste plus qu’à équilibrer les lumières sur les comédiens, et éventuellement retoucher légèrement l’étalonnage via une console émulant un pupitre Resolve sur place dans le studio... C’est une workflow qui suit les recommandations de Netflix et qui est validé HDR.

Et la question du flou récurrent sur l’écran ?

L’arrivée de l’écran LED, c’est comme l’arrivée du Steadicam dans la machinerie. Ça n’a pas remplacé la dolly, ça fait juste d’autres plans... Pour moi, c’est avant tout une technologie recréation de décor de soutien plus qu’un décor qui devient personnage principal du plan. En fonction du découpage, on pourra donc s’orienter vers une solution ou un autre. Selon moi, le plan traditionnel très large d’ouverture de séquence où tout est net, avec le lieu mis en avant sera toujours à faire en décor réel, ou en fond vert, par exemple, pour des lieux impossibles à construire. Et cela pour bénéficier de toute la latitude de définition et d’ajustement qu’offre la postproduction. En revanche, dès qu’on rentre dans le jeu, par exemple avec des champs contre-champs ou du découpage plus cut, le mur de LEDs devient parfaitement adapté – et plus rentable. Prenons un exemple classique : une scène de dialogue en bord de mer au coucher du soleil... Vous faites vos deux plans larges sur la vraie plage à l’heure idéale, les quelques pelures en parallèle qui vous serviront de fond. Il suffit ensuite de rapatrier le reste de la séquence devant le mur de LEDs et finir les plans de jeu avec les comédiens et le soleil qui reste tranquillement en place au bord de l’horizon...

Entretien avec Pierre Cottereau, directeur de la photographie

Pierre Cottereau est en pleine préparation d’Une belle course, le nouveau film de Christian Carion qui réunit Line Renaud et Dany Boon dans un "road movie" parisien... Ils ont choisi de tourner l’intégralité des scènes de véhicule sur mur de LEDs. Pierre nous livre en exclusivité ses premiers retours d’expérience.

Comment êtes-vous arrivés à choisir la production virtuelle ?

En fait je travaillais sur la question depuis déjà deux ans. J’ai eu l’opportunité de travailler en 2019 sur un programme court de Canal+ où je devais utiliser les murs LED installés dans leur studio. J’ai trouvé l’expérience très intéressante et de suite imaginé que cela pourrait être une vraie alternative au fond vert pour les séquences voiture. Quand le projet de Christian Carion m’a été proposé (fin 2019), j’étais en plein dans ces recherches, et j’ai dès le départ évoqué cette solution technique. A ce moment-là, aucune société de prestation de service dans ce domaine n’était présente sur le marché. Je me suis mis à envisager de faire louer des dalles et construire un studio pour l’occasion. La location de dalles de qualité, par le réseau des matériels de concerts, d’événementiel et prestataire TV est tout de même assez chère : 100 euros/jour la dalle de 50 x 50 cm… L’addition est vite corsée pour un 4 x 4 m ! Mais ça restait économiquement compétitif par rapport au fond vert.

Peu après, le confinement est tombé et tout s’est arrêté...

En sortie de crise, à l’été 2020, la prépa du film est repartie et soudain plusieurs sociétés proposant des murs de LEDs pour la prise de vues sont apparues. On a repris les recherches, avec le soutien actif de Christian Carion (qui est aussi son propre producteur sur ce film) et Stéphane Riga, son directeur de production avec qui j’avais déjà travaillé sur Le Chant du loup. Tous deux sont très impliqués dans cette démarche, car passionnés par les liens entre la technique et l’artistique...

Pourquoi ce film vous semble-t-il adapté à ce mode de tournage ?

Le film se passe pour près d’une heure dans un taxi en plein Paris. Line Renaud en est la comédienne principale, passagère du véhicule. Vu cette situation, les 92 ans de l’interprète (qui ne peut tourner que par demi-journée) et les contraintes de circulation qu’on connaît, le tournage en réel était inenvisageable et le tournage en studio s’imposait.

Partant de là et n’ayant aucune envie de gérer les écueils du tournage en fond vert, le tournage sur mur LED m’a paru être une vraie alternative.

Notamment car il oblige à tourner les pelures en amont du tournage (ce qui est malheureusement rarement le cas quand on fait du fond vert) et surtout elles deviennent plus simples à faire (une seule focale par axe). Ensuite il devient très simple d’avoir une vraie interaction lumière entre ce qui éclaire les comédiens et les pelures. Enfin le comédien conducteur étant immergé dans l’environnement, il est très facile de faire semblant de conduire.

Bref, au lieu de contrainte technique lourde et peu fructueuse artistiquement on a, théoriquement, un système qui nous permet de reprendre le contrôle de l’image dès le tournage.

Où allez-vous tourner ?

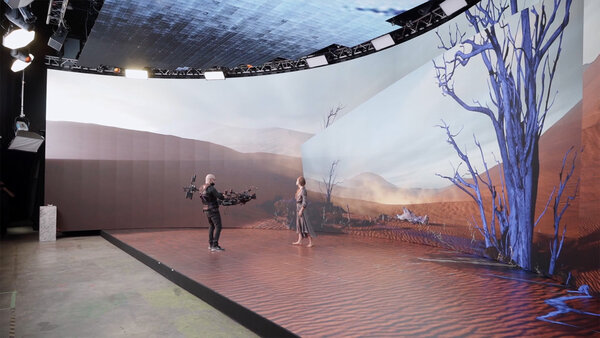

On a choisi de travailler avec l’équipe de Picseyes aux studios de la Montjoie (ex Studios AB à La Plaine Saint-Denis). Xavier Plèche en est le superviseur de production virtuelle (et producteur exécutif du film), tandis que Christophe Grellié en est le superviseur technique. Notre dispositif est assez simple, comparé à ce que nous proposait d’autres prestataires. On se contente d’un mur en L pour les découvertes avec deux panneaux linéaires de 8 x 3 m. La voiture sera placée sur des "gojack", permettant de basculer la position quand on change d’axe. Un petit écran servira pour le ciel et les réflexions sur le pare-brise avant, tandis que deux grands bandeaux LED (4,8 m x 0,60 m) et un totem LEDX seront aussi hors-champ pour assurer l’éclairage latéral et les reflets sur la carrosserie.

Je pense d’ailleurs personnellement que proposer des plateaux complets recouverts de LEDs du sol au plafond, c’est super mais encore un peu tôt pour le marché français de la fiction. Il faut vraiment y aller à petits pas mais sûrement pour apprivoiser les productions, montrer qu’on peut compter sur cette technique, et que c’est la meilleure alternative artistique, économique et technique pour tourner des intérieurs voiture. Je crois que ce mode de tournage, quelques soient les budgets de production, peut vite se démocratiser et paraître rentable à tous. Cela nous permettra alors d’être plus ambitieux et de s’attaquer à des plans qui utilisent l’ensemble des possibilités du système (univers virtuel, intégration à 360 degrés...)

Et les pelures ?

Pour les pelures, on a fait pas mal de tests. Le premier a consisté à filmer un personnage dans le véhicule roulant pour de vrai, tandis qu’une deuxième caméra accrochée en extérieur filmait uniquement l’arrière-plan. Installés ensuite avec la voiture dans notre studio, on a pu comparer l’image tournée en décor réel, avec une première version d’assemblage entre la pelure (tournée au même moment) et le personnage installé en avant-plan. Ce test nous a permis de juger de la cohérence du système et surtout de préciser la configuration idéale pour la captation des pelures. Finalement on a choisi de tourner sur voiture-travelling avec cinq caméras Sony Venice. Une de chaque côté pour les découvertes latérales (focale sphérique 14 mm), une dirigée vers le ciel (8 mm), une avant avec un Fish Eye Antalya (220°), et une arrière avec un 12 mm. Ce n’est pas une prise de vue à 360°, avec un "stitch" des images mais bien cinq clips séparés qui seront ensuite destinés simplement aux trois écrans (selon la position voiture).

Ce qui est vraiment intéressant, c’est qu’on peut tourner les pelures très efficacement.

Adieu les multiples passes en fonction des focales. De plus les raccords d’action autour du véhicule (scooter, vélo, piéton) sont assurés par les multiples axes et peuvent être exploités visuellement et au son.

Vous avez essayé la solution tournage 360° ?

Oui, notamment le rig RED Komodo six caméras de Jean Chesneau, mais la proximité avec les premiers plans (vélos qui frôlent le taxi, piétons qui traversent...) pose beaucoup de problèmes de parallaxe. A mon avis, ce genre de rig conviendra beaucoup plus à un tournage sur une route de campagne, où les distances minimales des objets aux caméras sont plus faciles à gérer.

Pourquoi cinq Sony Venice ?

J’ai choisi la Venice car c’est ma caméra principale pour le film (avec des Arri Master Prime anamorphiques). Je n’avais pas envie de me rajouter une contrainte supplémentaire en ayant des rendus colorimétriques différents entre les pelures et le "direct" (par exemple, sur les sodiums de nuit dont le rendu est très différent en RED et en Sony). Plutôt que de passer du temps en étalonnage, j’ai choisi de conserver cette unité dans le matériel. En tout, l’ensemble des pelures pour le film ne nous ont pris que trois jours de tournage.

Et pour le rendu de couleur des écrans ?

Pour la calibration, j’utilise une technique que j’avais déjà expérimentée lors de mes essais chez Canal+... C’est très simple et logique, et ça permet à tout le monde de suivre ! On filme simplement une charte avec la caméra, bien posée, à droite cadre devant le mur. L’image est envoyée au mur de LEDs, et on refilme en même temps à gauche, créant une multitude de renvois comme quand on se regarde de face dans un miroir avec un 2e miroir. Ainsi on visualise très vite le raccord en contraste et en couleur – et surtout on calibre le couple diaph-caméra et luminosité des LEDs. Éventuellement quelques retouches couleur s’effectuent, mais j’arrive avec cette méthode simplement à mes fins.

Comment allez-vous gérer les mouvements du véhicule ?

Là, il y a plusieurs chapelles, cinématographiquement parlant ! Sur Mank, où Fincher, par exemple, a utilisé un mur de LEDs (en noir et blanc), tout est très stable. C’est un parti pris. Personnellement je préfère quand c’est un peu plus le bordel ! Donc j’ai tenté de filmer les pelures sans antivibratoire. Mais la réalité des pavés parisiens m’a vite fait changer d’avis ! On va finalement essayer d’être dans quelques chose de réaliste, pas trop lisse mais sans "vibrations" techniquement dommageables.

Au final, j’ai pour l’instant un vrai plaisir à utiliser cette nouvelle technologie.

Les raccords lumière entre les pelures et l’intérieur de la voiture étant assurés par l’ensemble du dispositif, je peux tourner exactement comme en voiture embarquée avec les mêmes simples sources d’appoint. Je retrouve les sensations du décor réel mais avec tout le confort du studio.

Cela nous permettra, je l’espère, de dépasser la simple question du photoréalisme et de, peut-être, trouver quelques idées singulières...

Entretien avec Louis De Castro, Mado XR

Mado XR est une start-up parisienne qui vient de se lancer dans l’offre de services pour la production virtuelle. Avec plusieurs partenaires (Arri, le groupe TSF ou PRG, le géant américain des murs de LEDs depuis 30 ans dans le spectacle), ils proposent depuis le début de l’année 2021 un studio de production virtuelle aussi dénommé "Cave", dans le jargon des initiés...

Le groupe TSF, membre associé de l’AFC, a récemment annoncé l’équipement d’un de ses studios en dalles de LEDs. Et vous êtes la société qui a été choisie pour ce partenariat...

Effectivement, nous avons installé depuis le 3 janvier un studio XR (pour "extended reality") sur le plateau C du site d’Epinay (groupe TSF) avec le concours de nos partenaires principaux PRG, Nvidia, Epic Games et Arri. C’est un studio qui s’apparente à un "Cave" de réalité virtuelle, c’est-à-dire que les murs cylindriques sont recouverts de dalles, tout comme le plafond et le sol.

La taille du volume est imposante car il fait 15 m de large, 5 m de hauteur et 10 m de profondeur.... Actuellement en phase de tests et de démonstration avec nos partenaires, on accueille de nombreuses équipes de production pour leur faire découvrir ce nouveau mode de tournage où tout est généré en direct sur le plateau.

Y a-t-il eu déjà des scènes de long métrage tournées dans ce studio ?

Pour le moment, pas encore de films tournés sur place, mais de nombreuses expériences dans le domaine du corporate, comme pour Dassault System, ou de la mode comme pour Balmain avec lequel on a organisé un événement lors de la Fashion Week. Nous sommes également en étude et en prépa pour plusieurs projets de longs métrages et séries, mais je ne peux pas encore les dévoiler...

En enquêtant, on s’aperçoit vite que les premiers tournages sont surtout des scènes de voiture, en remplacement du tournage sur fond vert...

C’est vrai que la demande pour les scènes de véhicules est de loin la plus forte actuellement dans le milieu du cinéma. J ’avoue que je ne comprends pas trop le pourquoi du comment, vu l’amplitude des possibilités de la production virtuelle, mais j’imagine que c’est lié à la découverte de la technique, et que la maîtrise et les demandes plus ambitieuses vont venir assez vite. En tout cas nous avons déjà effectué quelques films démos avec l’intégration de personnages dans un univers virtuel entier (une forêt par exemple) qu’on peut voir sur notre site et nous sommes prêts à étudier toute demande.

Parmi les inconvénients cités, on note le problème du moiré qui peut apparaître de manière assez soudaine...Et qui force les DoP à jouer sur la profondeur de champ et laisser l’écran dans un flou plus tolérant...

L’apparition du moiré peut être évitée. Certes, c’est un phénomène très complexe qui dépend à la fois de la position du sujet par rapport à l’écran, la focale de la caméra, son ouverture et la profondeur de champ jusqu’à l’écran... mais également de la nature des dalles et surtout – je dirais même autant que le reste – de la qualité du processeur vidéo. C’est sur le respect de cette chaîne qu’on insiste, pour pouvoir, grâce à des outils de calcul développés en interne, évaluer la zone d’action idéale (entre caméra et comédien) sur le plateau, et éviter tout phénomène de moiré.

Arri est un leader dans les techniques de prises de vues cinéma... que vous apportent-ils ?

Notre partenariat avec Arri est central. Outre le matériel (SkyPanels, caméra, optiques), on a, par exemple, pu développer ensemble un outil important : une gestion colorimétrique de l’affichage des dalles (via un plug-in travaillant dans Unreal) entièrement calculé sur mesure pour le capteur de l’Alexa. Ainsi la chaîne de calibrage de couleur est respectée depuis les dalles jusque dans le capteur de la caméra. Autre innovation : on récupère le Camera Access Protocole qui permet d’exporter toutes les métadonnées internes de la caméra (diaph, distance mise au point, réglages divers...) pour les utiliser par la suite dans le cas où des retouches seraient éventuellement nécessaires.

Quelles sont les spécificités de votre écran en matière de couleur et de définition ?

Notre écran est capable de diffuser 4 flux en 4K temps réel à 60 i/s au maximum. Grâce à la technologie des calculateurs graphiques Nvidia, la colorimétrie est gérée en 10 bits, avec un passage imminent en 12 bits. Pour les images diffusées en arrière-plan, on privilégie un mélange de technique selon les besoins : objets 3D, photos très haute définition et photogrammétrie. Quand on part sur des pelures 2D, on privilégie toujours avant tout la qualité maximale de la capture comme en travaillant avec un rig six caméras RED Komodo. Notre partenariat avec le Groupe TSF nous permet d’ailleurs sur cette question de tester pas mal de configs possible et d’établir à terme une sorte de cahier des charges de la prise de vues de pelures destinées au "Cave".

En matière de LEDs elles-mêmes, nous avons équipé le studio de dalles ROE Black Onyx qui font partie des meilleures solutions actuelles. Elles sont légèrement mattes, et permettent d’avoir des noirs assez profonds. Grâce à notre partenaire PRG, on a pu bénéficier d’un lot de LEDs triées pour ne retenir que les meilleures. C’est ce tri qui fait la différence entre les dalles, et leur prix.

N’avez-vous pas peur que l’équilibre économique d’une telle installation aux standards hollywoodiens soient un peu compliqué à adapter au marché français ?

On a vraiment envie que cette technologie soit accessible au maximum et pas réservée seulement aux projets les plus aisés. Pour cela, on propose d’abord de la faire connaître, et aussi de s’adapter à toutes les situations. Les dalles étant modulaires, on peut aussi les installer dans une config plus réduite (simple découverte, prolongement de décor...) à un coût plus adapté. Pour vous donner un ordre de prix, une journée de tournage dans la config la plus simple pourrait démarrer à 5 000 € dans une configuration allégée (petit mur LED, découverte 2D) pour aller jusqu’à 35 000 € pour l’utilisation du "Cave" dans son intégralité avec gestion d’un univers 3D complexe. C’est, je pense, tout à fait compétitif quand on le compare avec un tournage fond vert et tous les coûts – parfois mal estimés – de ce qui va avec en post...

Entretien avec Christian Guillon, Les Tontons Truqueurs

Après près de trois ans de tournage à Montpellier du feuilleton TV Un si grand soleil, l’équipe des Tontons Truqueurs a dû affronter un grand nombre de situations et acquis une expérience solide de la production virtuelle en direct. Basée sur un "compositing" en temps réel entre des comédiens dans un décor réel partiel avec des fonds verts – et des découvertes ou prolongements de décors virtuels, la machine est désormais bien huilée avec une librairie de plus en plus étoffée de lieux réels modélisés en 3D. Christian Guillon vient faire le point avec nous sur la "hype" des "VFX On Set".

Tout le monde parle des écrans LEDs... mais vous ne les utilisez pas encore ?

C’est un peu l’arbre qui cache la forêt. Le succès de la série "The Mandalorian" et la communication qu’elle a générée sur ses méthodes de fabrication a surtout eu l’intérêt pour moi de parler des VFX sur le plateau. Et donc de faire connaître aux producteurs et aux techniciens cette nouvelle manière d’envisager un tournage. Un studio équipé d’un écran géant à dalles de LEDs ne fait pas tout. Pour nous l’objectif est avant tout de construire et maîtriser l’intégralité d’une nouvelle chaîne de production d’images hybrides entièrement basée Temps Réel.

Depuis la fabrication des éléments visuels destinés à l’intégration, jusqu’à la finalisation du film.

Je dirais que par rapport à cet objectif, on a beaucoup progressé sur les deux premières phases (fabrication des éléments virtuels dédiés et gestion en direct du dispositif sur le plateau), mais il nous reste encore un peu à faire pour totalement maîtriser les dernières étapes.

Pouvez-vous détailler vos avancées ?

Parmi les innovations, par exemple, on sait désormais sortir en Log les images truquées en direct. Ça peut paraître un détail... mais c’est un réel atout pour raccorder les plans "VFX On Set" au reste du film qui n’est pas forcément truqué. Autre avancée sur laquelle on progresse en ce moment, la possibilité de pouvoir intervenir directement sur le moteur de rendu 3D Unreal (l’outil principal des Tontons Truqueurs issu de l’univers du jeu vidéo). Grâce à cette sorte de "télécommande" qu’on a développée, on peut désormais facilement modifier des éléments "à la volée" sur le plateau selon les demandes de la mise en scène ; par exemple, déplacer tel ou tel objet dans l’univers 3D, modifier l’étalonnage, lancer des animations ou ajuster la position du soleil... On ne pourrait pas faire ce genre d’opérations sur le plateau si la chaîne de production n’était pas cohérente dans Unreal (si les "assets" étaient générés dans Maya, ou 3D studio Max par exemple). On parle de VFX on Set, sur un plateau, l’équipe de tournage ne va pas attendre deux heures que les gars des VFX modifient les arrière-plans. Nos outils sont adaptés au plateau : intuitifs et rapides.

Un autre exemple d’avancée est la possibilité désormais de puiser dans une librairie de décors 3D, de plus en plus riche, qui sont fabriqués de façon procédurale, et qu’on peut augmenter et réagencer comme on veut suivant les besoins de la réutilisation.

Et sur la fin de chaîne que vous mentionniez ?

Sur la sortie, on veut s’affranchir du format actuel du système, à savoir une sortie HD en 8 bits.

Pour cela nous allons proposer aux productions à venir le concept de "Near Time", qui consiste à enregistrer au tournage toutes les données du plan VFX, et à le lancer le soir même un recalcul complet du plan. Ce ne sera pas tout-à-fait en temps réel mais on recalculera les images dans la définition et l’échantillonnage souhaité, 4K, 12 bits, ou même plus si nécessaire. En outre ce recalcul se fera sur une version "gonflée" de la partie virtuelle 3D, plus riche en textures, avec des fonctionnalités comme le ray-tracing qui ne "passent" pas toujours en calcul temps réel pour cause de lourdeur. La postproduction devient alors une sorte de conformation, avec une sortie des plans "tournés-truqués" en léger différé de quelques heures. En termes de délai, c’est un peu comme quand on attendait le développement la pellicule... Pour cette R&D qui touche à son terme, le dernier obstacle sera de réintégrer le "compositing" dans une chaîne de production automatisée entièrement sous Unreal. C’est un soft qui a été mis au point pour le jeu vidéo et qui n’est pas prévu pour ça.

Trois ans de tournage… Quoi de neuf sur le plateau, de votre point de vue ?

On a commencé très modestement avec des découvertes fenêtres. C’est une application très simple mais récurrente au cinéma. Notre techno permet d’allier les avantages du fond vert postprod’ (incruster des décors animés et dont la perspective suit les déplacements de la caméra), avec les avantages des découvertes fixes et autres "translight" d’autrefois (avoir le résultat sous les yeux, et sortir les plans truqués avec les rushes). Aujourd’hui, nous en sommes aux extensions numériques de décors intérieurs : prolongements de couloirs, ajouts de pièces, ajouts de figuration 3D, animations des découvertes, etc. C’est le cas dans le nouvel hôpital du feuilleton, qui est tourné en studio mais qui donne à voir bien plus que ce qui est construit : un grand hall, des couloirs et la vue sur la ville par de grandes baies vitrées. L’enjeu est d’assurer la précision du "tracking" caméra qui ne souffrirait pas les cisaillements, ainsi que le raccord entre les textures du décor réel et leurs prolongations virtuelles. Le tout en temps réel, ce n’est pas si aisé…

Mais revenons au studio LEDs... Vous ne voulez décidément pas en parler !

Mais bien sûr que si ! Chaque solution a ses propres avantages et ses propres limites... Pour la prise de vues sur écran LEDs, l’avantage principal, c’est bien entendu le rendu "en direct" pour toute l’équipe, du comédien au chef électricien... L’écran devenant source de lumière, et le mélange étant visible, la cohérence de l’image se fait sur le plateau, et le contrôle du "compositing" final redevient le privilège du chef opérateur.

Le plus gros handicap artistique des LEDs, aujourd’hui, c’est l’impossibilité de faire la mise au point sur le fond. Avec le point sur les dalles et/ou dans certains rapports géométriques écran/capteur, du moiré apparaît sur l’image. Il faut donc laisser les arrière-plans hors de la profondeur de champ et parfois modifier sa focale et/ou sa place caméra pour éviter ce défaut.

Par ailleurs, l’utilisation des écrans n’est vraiment intéressante que si les images diffusées sont calculées en temps réel avec "tracking" caméra. Si on se contente de diffuser des prises de vues réelles en 2D, il n’y a pas de cohérence géométrique entre la position de la caméra et l’image diffusée. Les écrans LEds ne nous permettent donc de nous affranchir ni du calculateur temps réel, ni des systèmes de "tracking".

On voit que dans certains cas d’usage, le tournage VFX On Set en direct sur fond vert est beaucoup plus souple. On peut faire une bascule de point sur le décor, voire sur un personnage virtuel, et on peut tourner à plusieurs caméras sur le même fond (chaque arrière-plan est généré spécifiquement pour chaque caméra).

Notre projet est donc, outre de maîtriser la chaîne de production complète Temps Réel, de proposer à chaque étape de cette chaîne des alternatives : à l’étape du tournage, nous aurons le choix entre Ecran LED ou Fond Vert Temps Réel.

Dans les deux cas (Fond vert ou dalles LEDs) , il y a une vraie réappropriation de l’image par l’équipe sur le plateau. Même si les techniques diffèrent un peu, le résultat final est visualisé immédiatement. Les allers retours en postproduction (qui dépossédaient un grand nombre de directeur de la photo du contrôle des séquences truquées) n’existent plus...

Je pense qu’il faut savoir utiliser chaque configuration selon les besoins et les budgets de chaque projet.

Par exemple, à Montpellier, où nous tournons Un si grand soleil, en plus des deux plateaux de 1 100 m² déjà équipés avec notre technologie, on s’apprête à construire un troisième plateau en fond vert, tandis qu’un quatrième plus petit (600 m²) va bientôt voir le jour, avec une solution mixte LEDs / Fond vert (deux faces ½ vertes, une face ½ LED).

Ce sera un équipement conçu en connaissance du marché, c’est-à-dire qu’on pourra proposer à un prix journalier abordable pour des productions de longs métrages français petit ou moyen budget, ainsi qu’à des feuilletons ou séries...

C’est quand même le contexte idéal une aussi longue production pour mettre au point un tel outil ?

C’est une chance incroyable d’avoir pu démarrer sur ce feuilleton et nouer cette relation avec France 2 (qui a participé via une levée de fonds à l’aventure VFX on Set). Le long cours est le laboratoire parfait pour expérimenter et peu à peu maîtriser tous les aspects d’une telle chaîne. Vu l’évolution de la production et l’importance grandissante que prennent les séries dans la création de contenu, je pense que la production virtuelle va s’amplifier. Même si chaque série n’est pas autant synonyme de récurrence qu’un feuilleton, tourner six mois d’affilée pour une saison, puis réenchaîner six mois l’année suivante dans les mêmes décors est une chose désormais courante, qui fait prendre tout son sens à l’association de nos technologies innovantes avec les studios. La production virtuelle devient une vraie option.

Au fond – sans jeu de mot – c’est l’arrière-plan 3D qui prime, non ?

Tout est important dans une chaîne, il ne doit pas y avoir de maillon négligé, mais la fabrication des éléments virtuels est évidemment essentielle. La pelure tournée sur commande va disparaître, car l’avenir proposera bientôt des librairies très complètes de lieux réels – ou imaginaires – entièrement modélisés, qu’on pourra aménager selon les besoins...

Par exemple, ici, à force de créer de nouveaux environnements pour nos clients, nous commençons à avoir modélisé en 3D une partie de la ville de Montpellier. On peut très bien imaginer dans un futur proche proposer à un metteur en scène une ville entièrement recréée en 3D dans laquelle il choisira son trajet pour une scène de voiture, ou ses découvertes pour tel ou tel décor intérieur. Des univers où l’ambiance lumière, la saison, la météo, la vie urbaine – et à terme l’époque – seront des commandes annexes. Nous n’y sommes pas encore, et il faudra toujours un chef déco pour rendre singulier chaque décor pour chaque film, mais cette singularité se fera sur une base de données.

En vignette de cet article, le plateau des studios de la Montjoie en tournage.

En

En Fr

Fr