Vers la Couleur – 2e partie

Conversation entre Caroline Champetier, AFC, et Martin Roux – Décembre 2020Caroline : Ce qui est frappant au moment du basculement à la projection numérique – dont tu as dit que ça a établi une conjoncture entraînant une perte de repères dans la chaîne de fabrication des images –, c’est que pour la première fois on a inversé le processus.

Dans une pratique de l’origine, où il y a un début et une fin (négatif-positif-projection) et dont Kodak, entreprise apparue au cours du XIXe siècle se souciait fortement (en travaillant sur les progrès du support du Technicolor au Monopack, les ingénieurs se posent la question de la couleur à partir du négatif), soudain, les majors américaines décident d’annihiler la projection argentique dernière opération du processus, ils ne se soucient plus de l’origine, c’est la fin de la chaîne qui va dicter sa loi au début de la chaîne. Ils veulent réduire les coûts sur le tirage des bobines positives. C’est un raisonnement totalement libéral, comme si les studios étaient en fait plus libéraux que Kodak…

Martin : Le bémol, c’est qu’aux Etats-Unis, dans les majors américaines, il y a un très grand pragmatisme sur la question des coûts et en même temps ils restent extrêmement conservateurs sur la question esthétique. Donc ils tempèrent ce pragmatisme libéral par rapport à ce que la France a connu. Parce que nous, nous avons réellement scié la branche sur laquelle nous étions assis.

Caroline : Ils sont conservateurs d’un point de vue esthétique parce qu’ils sont compétitifs. Ils savent, en tant qu’industrie, ce qu’ils doivent aux principes fondateurs.

Ce qui nous frappe tous les deux, c’est le fait que dans l’industrie du cinéma français on est dans une économie libérale et même dans un état d’esprit esthétique qui est libéral.

Martin : Oui, parce que pour le coup Kodak n’était pas laxiste, puisqu’ils étaient dans une recherche de savoir, d’ailleurs la période imposait ça : quand la firme commence à fabriquer de la pellicule, au début du XXe siècle, on n’a pas encore observé de manière physiologique la trichromie de l’œil, on ne sait pas grand chose… Ça force tout le monde à l’humilité. Maintenant on a l’impression qu’on sait parce qu’on est usager d’images et qu’on en consomme... Ça crée une sorte de loi du marché.

Caroline : L’apparition de la trichromie, ou de l’analyse de l’œil, c’est quelle époque ?

Martin : La première théorie sur la trichromie et les premières expériences c’est au XIXe siècle, mais l’observation physiologique de l’œil et la confirmation de l’existence des cônes, c’est 1956 (par Gunnar Svaetichin). Il y a plusieurs coïncidences de ce type dans les procédés photographiques, après coup on découvre que l’œil fonctionne de la même manière que les supports sensibles. C’est pareil pour la loi de Weber-Fechner et la réponse logarithmique des supports sensibles. Il y a une grande ignorance et très peu d’entités savantes, donc Kodak est dans une situation de monopole du savoir mais ce monopole, c’est l’inverse d’un libéralisme de l’image puisqu’ils imposent une direction. Alors qu’aujourd’hui il y a une multiplicité de propositions.

Caroline : Tu as déjà parlé de cette incohérence des propositions.

Martin : Elle existe déjà au niveau des outils, quand on fait la proposition de six formats HDR différents, plusieurs niveaux de blanc en projection ou sur des écrans, untel dit 2 000 nits, d’autres disent 1 000 nits... et personne n’a fait de tests psychophysiques pour déterminer le point de confort de l’œil.

Caroline : Mais le point de confort où ça ? Sur les écrans géants de Shibuya au Japon en plein jour ? A Shibuya la nuit ? A New-York à Time- Square ? Ou dans un salon sur un écran domestique ?

Pour regarder des images il y a quelques situations qui sont normées, la salle de cinéma en est une, tout le monde est dans le noir, c’est une situation stable dans toutes les salles du monde. Mais n’as-tu pas l’impression que justement, c’est la salle de cinéma que ces pratiques mettent en cause ?

Martin : Oui mais même sur les écrans domestiques le problème se pose. Personne n’a 30 000 lux dans son salon, quand on vend un écran de télévision qui donne 3 000 nits (3 000 cd/m²) pour les blancs, ce qui est énorme, poser la question du point de confort semble évident. Comme sur la définition : à quel moment dit-on que ça ne sert à rien de rajouter des pixels ? Qui fait des essais psychophysiques aujourd’hui pour régler ces questions ?

Caroline : On pourrait effectivement faire des essais, mais qui y a vraiment intérêt ? Faire une corrélation entre le niveau lumineux ambiant et le niveau qu’il faudrait sur l’écran n’est pas très compliqué. La somme des propositions n’est guidée que par la vente de matériel. On revient au fait qu’on est au bout du geste.

Martin : Avec une rhétorique qui pour le coup est libérale : si le consommateur le veut alors personne ne peut s’opposer à ça. Si le consommateur veut un écran 4K de 3 000 nits alors faisons-le.

Caroline : S’il est aveugle dans dix ans et ses enfants aussi, ce n’est pas grave.

Martin : C’est curieux parce qu’il y a des sens sur lesquels on est beaucoup plus vigilant et on a beaucoup moins de mal à se poser la question de la norme : par exemple le son. La surdité se provoque plus facilement que la cécité, on s’abîme plus vite les tympans qu’on ne s’abîme les yeux. Si quelqu’un disait : « Moi je veux écouter 200 décibels s’il vous plaît », tout le monde dirait que c’est n’importe quoi.

On a du mal à mettre en cause la justesse du jugement visuel, et ça c’est une logique occidentale. L’occident est fondamentalement cartésien, et pour Descartes, « voir c’est savoir » : on estime que si vous faites l’expérience visuelle de quelque chose, vous savez.

Caroline : Donc dans notre pratique à nous, puisque ce qui nous intéresse, c’est le traitement des images, ce que tu estimes être le comble du libéralisme, c’est un endroit où on arrive avec son RAW et où on pourrait faire ce que l’on veut au moment de l’étalonnage.

Martin : Oui, ce que l’on veut à l’étalonnage, ce que l’on veut comme norme de diffusion, en projections ou sur moniteurs, SDR / HDR, bref une sorte de carrefour de tous les possibles, et plus aucune forme de prescription. C’est l’inverse de ce qui s’est passé pendant les 100 années précédentes.

Caroline : Pendant les 100 ans de "dictature Kodak".

Martin : C’est contradictoire, parce que les démonstrations de toutes les études psychophysiques qui parlent du visuel, c’est qu’il y a des convergences considérables : tout le monde voit la même chose et tout le monde préfère la même chose.

Caroline : On revient au début de ce que nous disions, c’est-à-dire qu’aimer voir quelque chose, c’est avoir l’impression que c’est comme ça que l’on peut ou veut s’en souvenir.

Martin : Cette espèce de libéralisme sur les possibles ne correspond à rien en termes d’attente. Au fond ce n’est pas vrai que les gens ont des attentes si différentes et surtout que les gens savent ce qu’ils attendent.

Caroline : Ça c’est le principe cynique et chaotique poussé à son terme, faire croire aux gens que chacun a une idée des choses donc que chacun verrait un rouge ou un vert ou un bleu comme il le souhaite.

Martin : Et donc, du coup, quand tu vas dans ce sens-là dans l’organisation du travail, ça sous-entend qu’il faut laisser les gens décider tout seuls et arbitrairement de comment procéder avec toutes leurs incapacités physiologiques.

Peu d’étalonneurs, comme peu de directeurs de la photographie, reconnaîtraient aujourd’hui leurs insuffisances perceptives mais si on faisait des tests de reconnaissance de couleurs sur ces populations-là, on trouverait des résultats pas très différents de la population globale. On ne progresse pas beaucoup par rapport à nos capacités perceptives, il y a un peu d’éducation du regard. Au fond on reste tous humains pourtant il y a une négation du principe de l’humain au profit d’une logique du « faites ce qui vous plaît ».

Caroline : C’est le contraire qui se passe. Loin d’être libres nous sommes complètement manipulés par cet état chaotique dans lequel nous nous trouvons. Donc ce que j’aimerais qu’on arrive à définir ensemble, c’est à quel moment un outil arrive qui nous fait non pas comprendre mais en tout cas réfléchir un peu différemment. Comment se fait-il que toi et moi, à un moment donné, on s’est mis à refuser et à sentir que nous étions dans une situation chaotique ? Est-ce que c’est un outil ? Est-ce que c’est l’absence d’un outil ?

Martin : J’ai l’impression que c’est la cinéphilie. Ce qui m’a souvent choqué, c’est le décalage. A cause de l’avancée des technologies, il fallait accepter une expérience de spectateur que je trouvais moins satisfaisante...

Caroline : Le plaisir de voir une belle copie argentique restait...

Martin : Ce n’est même pas qu’une copie soit argentique parce que je dois dire que la question de la projection est un débat à part : il y a de bonnes projections numériques…

Caroline : Quand je dis projection argentique, c’est l’expérience du travail argentique de la couleur sur une copie projetée.

Martin : C’est aussi un truc de formation. Je suis rentré à l’Ecole Louis-Lumière en 2009 alors qu’on était en argentique et en 2010, il y a la présentation de l’Alexa, c’était LE moment. On a vu l’argentique fondre comme neige au soleil tout en étant dans une école où tu imagines bien que les conditions de postproduction numérique étaient vraiment légères.

Je trouvais qu’on nous montrait des choses pas belles et il y avait un discours qui nous disait que c’était la technologie qui le voulait. Cela advenait… il fallait accepter la conséquence esthétique de ce changement de technologie.

Caroline : A peu près au même moment – ce que je vois précisément étant sensible aux carnations – c’est qu’il n’y a plus de belles peaux et que dans tous les films il y a une grande déperdition du travail sur les carnations.

Martin : Heureusement il y a quelques films qui contredisent tout ça et sont un peu des balises, tournés en numérique et postproduits en numérique, par exemple Zodiac...

Caroline : J’allais le dire. Zodiac tourné en caméra Viper, en 2007, avec une sensibilité qui n’est pas la sensibilité du numérique aujourd’hui et même pas la sensibilité du film à cette époque…, une sensibilité de 250 ISO.

Martin : C’est une caméra qui n’a pas les atouts flatteurs des caméras numériques d’aujourd’hui. C’est un tank. C’est une caméra avec laquelle on a fait des films en France pas si satisfaisants que ça : donc c’était la même caméra mais pas du tout le même rendu. On ne pouvait plus convoquer des histoires de produits chimiques miraculeux, ça n’était plus que des maths. Tout était donc devenu possible dans la mesure où on avait les bons développements mathématiques derrière.

Caroline : Là, on met le doigt sur la différence entre ce qui s’est passé aux Etats-Unis et en France.

Martin : Oui avec en l’occurrence David Fincher, dont on sait maintenant, parce qu’il a continué à faire ça, qu’il a une intelligence de la postproduction numérique qui dépasse de loin celle des gens de sa génération. Il est le chef de file d’une postproduction numérique extrêmement exigeante. Ces films balises font la démonstration qu’il n’y a pas de raison de faire le deuil d’une image agréable d’un point de vue perceptif.

Caroline : Je te rappelle que quand l’Alexa arrive en 2010, quand vous êtes étudiants à Louis-Lumière, elle n’enregistre que du ProRes.

Martin : Oui mais le ProRes a été créé pour concurrencer le télécinéma Super 16 et dans cette utilisation-là, c’était plutôt un bon format. Il y a eu un terrible malentendu et en plus un malentendu français parce que je pense qu’on était plus enclins à faire tomber nos chaînes de postproduction et à faire des économies que les Anglo-Saxons. Le ProRes, si on le limite à ce que c’est, n’est pas la pire des choses, il y a de beaux films en ProRes.

Caroline : Comme de beaux films en inversible, on est juste limité en échantillonnage.

Martin : Le Log a fait plus de mal que le ProRes, pas du tout parce que le Log c’est mal mais dans le quiproquo qu’il y a eu par la suite sur le fait qu’il fallait travailler le Log tel quel.

A cause des pratiques en publicité, à cause de toutes ces chaînes de postproduction extrêmement rapides où on prenait le fichier Log et où on travaillait le contraste directement.

En réalité dans le "ProRes Log", ce qui a été terrible dans l’éducation des gens à la postproduction, c’est le Log. Pourtant il n’y est pour rien parce que ça n’est qu’une formule mathématique pour coder des valeurs. Les gens de Kodak qui l’ont inventé (c’est Kodak qui a inventé le Log pour les besoins du scan) n’ont, je pense, jamais imaginé que des gens se le projetteraient en salle en trouvant ça sympa…

[Histoire des fous qui apprécient une piscine dans laquelle il n’y a pas d’eau – Caroline ne sait plus comment la raconter...]

Caroline : Donc ce Log est en fait une réponse de Kodak, créé pour un outil numérique, le scan, afin d’interpréter la pellicule négative.

Martin : Quand ils inventent les premiers scanners dans les années 1990, faire du 10 bits, c’est déjà ambitieux informatiquement. Et si tu veux coder 15 diaphs en 10 bits tu ne peux pas le faire en linéaire donc Kodak crée une courbe qui répartie mieux les informations.

C’est juste une étape du codage pour permettre de coder sur 10 bits plus d’informations. Ce sont des mathématiques intelligentes, justement des maths qui pourront être dissoutes par une autre formule mathématique inverse. Il y a un Log et un Log inverse. Il y a plein de Logs différents en fonction des objectifs qu’on veut atteindre mais en réalité ils ont tous la même propriété d’avoir une formule inverse.

Caroline : Qu’est-ce qui fait que le Log est pris à la lettre dans les labos français et pas dans les labos américains ?

Martin : C’est dû à la suppression du bloc retour film. La LUT retour film existe pour te donner une simulation de tirage à partir d’un espace scan Cineon Log et à partir du moment où on retire cette brique-là parce qu’on ne veut plus tirer en film et qu’on ne veut plus de la contrainte, à juste titre en partie, on se retrouve avec le Log tout seul.

Caroline : Cela me fait penser à Marguerite et Julien, photographié en film et en numérique par Céline Bozon. Elle garde l’étalon Kodak qui tire vers le haut les parties tournées en RED.

Martin : Oui parce qu’en plus il faudra lui demander mais dans Marguerite et Julien, j’imagine que comme elle avait du scan 35 mm, elle avait dû mettre une LUT retour film ou un équivalent positif.

Caroline : Quand tu as un fichier Log et aucune consigne de développement, aucune courbe, tu es en totale apesanteur.

Martin : Le libéralisme est aussi à cet endroit-là... Si vous voulez travailler à partir de ça, « allez-y, nous on vous force à rien, faites comme vous voulez… »

Il y a aussi ce truc de l’informatique grand public : les gens ont accès à des ordinateurs de plus en plus performants. Avec ton petit Mac, tu peux lancer QuickTime et ouvrir ton rush. C’est ça que les gens découvrent avec le ProRes de l’Alexa : tu double-cliques sur le rush et tu vois la prise dans sa qualité réelle. Donc il y a une vulgarisation, et d’un coup le rush devient trivial, on peut le mettre dans le logiciel de montage comme ça, on peut s’habituer à cette image-là, on peut bricoler dessus, se rendre compte qu’on peut y redonner un petit peu de contraste... bien sûr on peut redonner un peu de contraste, un peu de saturation et imaginer qu’on a fait quelque chose...

C’est la vulgarisation des outils et Da Vinci va complètement dans ce sens-là. On passe de logiciels d’étalonnage qui coûtent 100 000 € à un logiciel qui coûte 250 $, évidemment tout le monde se prend pour un labo. Je n’ai rien contre cette démocratisation des outils, j’en profite comme tout le monde. Mais elle comporte une part de piège, dans ce qu’elle nous fait croire de nos capacités.

Caroline : Les outils sont entre ce qu’on regarde, ce qu’on filme ou ce qu’on photographie et les images. Cette question du monceau d’images fait qu’on ne se pose plus la question de comprendre le geste qui les a faites pour être ce qu’elles sont. En fait les images dialoguent entre elles et elles ne se rapportent plus à un geste, à une origine : ce sont juste des images en apesanteur.

Martin : La question du monceau d’images va dans le même sens que la question de la vulgarisation et de l’ouverture des outils au grand public, c’est-à-dire qu’elle donne le sentiment que c’est facile de fabriquer des images, ce qui au sens littéral n’est pas faux, mais quelles images ?

Les images de cinéma proposées par Kodak étaient des images aristocratiques qui avaient un coût, et dans lesquelles il y avait énormément de savoir et d’attention...

Caroline : Ces images étaient destinées à travailler sur le souvenir, ce qui est frappant dans Histoire(s) du Cinéma justement, c’est à quel point ces chocs – que tu as appelés « chocs cinéphiliques » tout à l’heure et que l’on pourrait aussi appeler chocs visuels – que Godard a emmagasinés pendant ses 4/5 années de Cinémathèque induisent une émotion. Et cette émotion-là il ne peut plus s’en écarter tant que ça.

En fait l’origine de l’image n’est pas le réel, l’origine de l’image c’est le travail mémoriel qu’on va faire pour se souvenir d’une image dont on va décider qu’elle est digne du souvenir. C’est tout ce que démontrent les recherches psychophysiques de Kodak. C’est quasiment de la philosophie, celle de Bergson en tout cas, contemporaine de l’invention du cinéma.

Martin : Oui on fabrique un souvenir.

Caroline : Parce qu’une image de cinéma n’est pas faite pour être immédiate, elle est faite pour qu’on puisse s’en souvenir. Dans ce temps, dans cette durée, il y a la place pour l’artifice, qu’on pourrait appeler « interprétation ».

Martin : Nous-mêmes interprétons le réel avec notre système perceptif donc ce n’est pas un gros mot du tout. La vulgarisation des outils laisse penser à tout le monde qu’on peut fabriquer des images. Mais ce qui disparaît entre temps, c’est la science de ces interprétations-là.

Caroline : Donc après quelques années à s’être bien tapé la tête contre les murs, des outils apparaissent dont on a le sentiment qu’ils nous permettent cette interprétation.

Martin : Tu penses à quoi, par exemple ?

Caroline : Je pense, entre autres, au Baselight.

Martin : FilmLight n’a jamais vraiment quitté ce champ de l’industrie rare et savante du cinéma, c’est une société qui fait des scanners donc ils ont toujours été dans des processus chers et savants. Ils ont mis des années à développer un système de gestion d’espaces couleur, de mapping perceptifs de la couleur, c’est-à-dire avec leurs propres développements mathématiques.

Caroline : Et sur la texture également, pas seulement sur la couleur.

Martin : Tu as raison, par ailleurs tout ce qu’on dit sur la couleur est vrai aussi sur la texture, il faudrait en faire une deuxième discussion.

Donc, qu’est-ce qui fait qu’il y a des outils qui émergent ? Rien... D’une certaine manière il y a des gens qui n’ont jamais perdu le contact avec l’exigence, ce sont les grandes firmes de postproduction dont Eclair est un exemple, mais dans l’ensemble ce sont plutôt des firmes anglo-saxonnes, elles ont gardé une idée très précise de ce qu’il fallait faire parce que quand ils faisaient de la 3D de toutes façons ils fabriquaient la couleur à 100 % et étaient obligés de se poser la question de la couleur : il fallait tout mapper, il fallait tout décider. Donc c’était des gens qui étaient soucieux de ce qui était satisfaisant, de ce qui était beau, de comment ça aurait été rendu en pellicule.

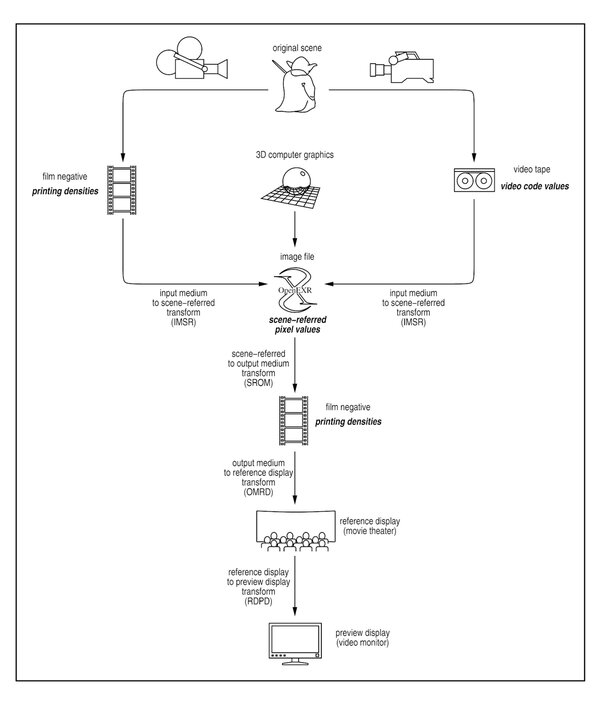

C’est ceux qui ont posé les bases de l’ACES qui par ailleurs a été largement pris par FilmLight. L’architecture philosophique de leurs logiciels, c’est en partie ACES .

Caroline : Sur Annette, j’ai travaillé sur Baselight mais pas en ACES parce que nous avions l’impression que l’analyse du X-OCN XT n’était pas encore tout à fait au point...

Martin : Je ne sais pas comment tu as travaillé sur Annette mais ACES, c’est très normatif. En fait le problème d’ACES, c’est que c’est à la fois très normatif et un peu démocratique puisqu’en fait c’est un regroupement d’industries : du coup c’est le bordel. C’est une norme très forte, puisque quand tu es en ACES tu as vraiment un look, quelque chose qui vient se plaquer sur ton image, mais fait par des gens qui échangent entre eux et qui n’ont pas tout à fait les mêmes conceptions.

Donc FilmLight a fini par dire qu’ACES c’était intéressant mais qu’ils allaient faire une sorte d’ACES bis parce qu’ils n’avaient pas envie d’avoir les mains liées avec les autres gars... Il y a des forums entiers où ça discute sur ACES, les mecs ne sont pas d’accord sur comment il faut que soient les jaunes, etc., et ça finit par faire un truc qui déplaît à certains étalonneurs et manque un peu de souplesse parfois. Par ailleurs ACES ça vient d’une proposition de ILM (Industrial Light and Magic), une boite américaine d’effets spéciaux qui un jour a déclaré : « Nous, c’est comme ça qu’on fait », c’est-à-dire qu’on fait une transformation d’entrée de toutes les caméras pour aller vers notre espace couleur à nous, puis on a un bloc qui est le développement, puis on a une transformation de sortie pour aller vers la projection, la vidéo, et on trouve que c’est beaucoup plus pratique sous telles et telles conditions pour intégrer des effets spéciaux ou pour mélanger du 35 mm et du numérique.

Ils ont fait cette présentation en 2004, et à partir de là, il y a eu un travail collégial de recherche pour proposer un système universel.

Caroline : Oui mais comment ILM est arrivé à ce raisonnement qui amène un espace de travail hors capteur.

Martin : Ils en ont eu besoin parce que dès lors qu’ils ont commencé à faire de la 3D et du 35 mm en même temps, ce qui a duré quand même un moment (il y avait des films américains avec beaucoup de 3D mais aussi beaucoup de 35 mm parce que les caméras numériques n’étaient pas encore au niveau), ils avaient besoin d’unifier des sources très différentes. Il fallait garder la "garantie de bonne fin" d’une postproduction 35 mm et en même temps pouvoir agréger plusieurs supports. Donc on retrouve ce qui sera plus tard les IDT (Input Device Transform), les ODT(Output Device Transform), etc. Il y a l’idée de travailler dans un espace universel, vers lequel convergent toutes les sources d’image, et depuis lequel on peut aller vers différents types de diffusion. Il y a aussi l’idée qu’il y a un bloc de développement mathématique.

Cela sert de brouillon à l’ACES, sauf que l’ACES mettra des années à émerger parce que comme c’est un processus collégial, ça prend beaucoup de temps, les gens ne sont pas d’accord, ils pinaillent sur des points. L’ACES est aujourd’hui en version 1.2, c’est un bébé, alors que ça fait plus de 15 ans que ILM a formulé la première proposition. Ceci dit, cela a fini par imposer un schéma de pipeline de postproduction : on veut faire sauter les spécificités esthétiques des caméras, on veut un développement qui nous rende la saturation et du contraste et on veut pouvoir aller vers n’importe quel type de diffusion avec du coup différents rendus en fonction de si on est en projection ou en vidéo.

Caroline : En fait ce que je comprends concernant l’espace couleur, ce qu’on veut et ce que tous les directeurs de la photo aimeraient, ce serait que ce ne soit pas celui de la caméra mais que ce soit un espace couleur postérieur à la sortie de capteur qu’on puisse travailler de manière normée.

Martin : Oui, on veut un espace couleur neutre qui permet de faire converger toutes les caméras au même endroit donc de revenir en arrière pour que toutes les caméras se ressemblent et que si on décide de développer des outils de look on puisse les appliquer à n’importe quelle caméra. On veut pouvoir aller facilement de cet espace couleur qui est l’espace couleur de travail vers un rendu développé minimum, c’est-à-dire une image qui se regarde.

Caroline : Pour être plus précis, une image qui se regarde, c’est une image qui se situe dans une norme de contrastes qui sont ceux auxquels on est habitué.

Martin : De contraste et de saturation, et aussi qui respectent les niveaux de pose.

Ce n’est pas rien non plus, il faut que ce soit un tirage qui respecte le niveau de pose et que dans tout ça tu aies une forme de continuité entre toutes les sources de captation et que tu puisses travailler dans cet espace.

Cet espace, c’est l’endroit où tu joues le match et il faut que tu sois content de là où ça se joue... Ensuite que ce soit un espace où ce soit facile de faire des transformations esthétiques un peu générales qui vont te permettre d’influer sur le développement.

ACES est bâti complètement comme ça avec les limites que je formulais avant, c’est-à-dire qu’il y a des trucs un peu normatifs, un peu rigides. Certains ne sont pas contents des rendus de saturation dans ACES, du contraste, des choses comme ça. Mais au moins ça a le mérite d’être mis sur le papier et c’est disponible, ACES est disponible pour tout le monde.

Pour Baselight, ils ont pris ce qu’il y avait d’intéressant dans ACES, c’est-à-dire la convergence des caméras vers le même endroit, mais ils ont proposé un autre type de développement (Truelight) plus doux, plus souple, puis ils ont construit des looks sur cette base-là.

Il y a d’autres propositions, ColorFront par exemple, et puis il y a des labos qui ont des propositions autonomes. Amazing Digital Studio, avec qui nous avons travaillé, n’est ni sur ACES ni sur Baselight, mais à 100 % sur ses maths à lui. Dans la philosophie, c’est la même chose, il veut que les caméras convergent, pouvoir mettre les choses le plus près possible les unes des autres. Raccorder deux caméras à l’œil, comme une RED et une Alexa, uniquement perceptiblement en regardant l’écran alors qu’elles ne sont pas dans le même espace couleur, c’est un truc de zinzin, tu ne parles pas la même langue et attends de voir le moment où ça va se superposer, c’est un truc de fou, il ne faut pas faire ça !

Caroline : Et pourtant ça se fait tout le temps.

Martin : Alors quand tu as des caméras de la même marque, tu as le même espace couleur, c’est bon.

Caroline : C’est pour ça que nous avons travaillé en Sony-Sony.

Martin : Ça marche aussi plus ou moins en RED-RED, il y a des fabricants plus ou moins sérieux... Quand Blackmagic Design fabrique des caméras, il n’y en a pas deux pareilles...

Les fabricants sérieux font ça bien mais en réalité même les spécificités fabricant, on a envie de les faire sauter. S’ils avaient su être prescripteurs de goûts et de looks on resterait chez eux mais en réalité personne n’a repris ce flambeau là. Sauf peut-être Arri quand ils se sont rendu compte que l’étape manquait.

Caroline : Alors un petit bémol moins important que l’autre question que j’ai à te poser sur les espaces couleur, c’est que Sony, dans l’échantillonnage de la couleur, me semble plus avancé.

Martin : Oui mais le problème de Sony, c’est que la proposition esthétique qu’ils font est extrêmement performante colorimétriquement mais du coup elle n’est pas satisfaisante à l’œil. Les verts de Sony donnent l’impression d’avoir trop de saturation.

Caroline : Alors, quand on n’est pas mathématicien, comme moi, comme toi, comment fait-on pour pouvoir appréhender un espace couleur ?

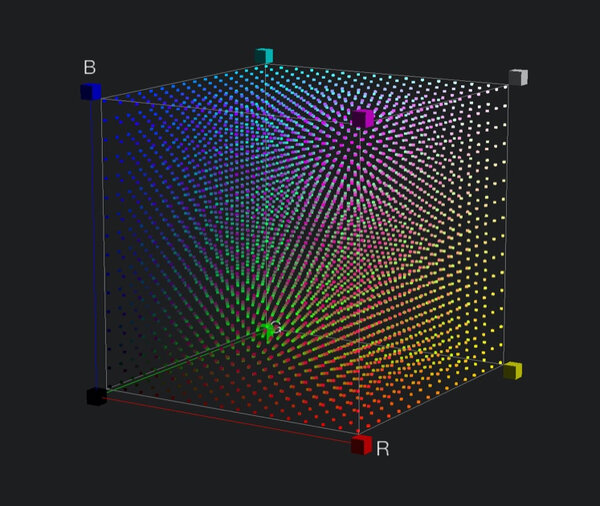

Martin : Le bon échelon de raisonnement, ce sont les volumes. Il y a des moyens de représenter la couleur sous forme de volumes.

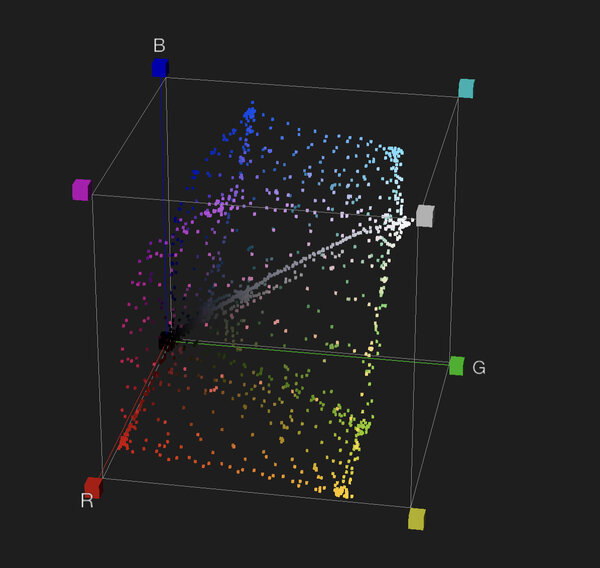

La figure 1 est un espace RVB, ça peut être n’importe quel R, V ou B. Ce sont les trois coordonnées dans l’espace – c’est de la géométrie dans l’espace – et donc à la fin quand tu as 1, 1 et 1 partout, tu es au blanc. A l’inverse le coin opposé, c’est le noir, les valeurs 0, 0, 0. C’est ce qui se passe dans le signal, quand tes pixels R, V et B sont au maximum, ça fait du blanc, quand ils sont au minimum, ça fait du noir et entre les deux il y a toutes les couleurs.

La Fig. 1 est un espace RVB plein et encore une fois, ça peut être n’importe quel espace RVB au sens où tous les espaces dont on parle sont des espaces RVB car ce sont les espaces des caméras. Si tu veux le Rec 709 tu peux faire un cube, c’est juste que le cube n’aura pas la même taille que le cube du P3 qui est plus grand, mais dans un espace donné tu peux toujours faire un cube.

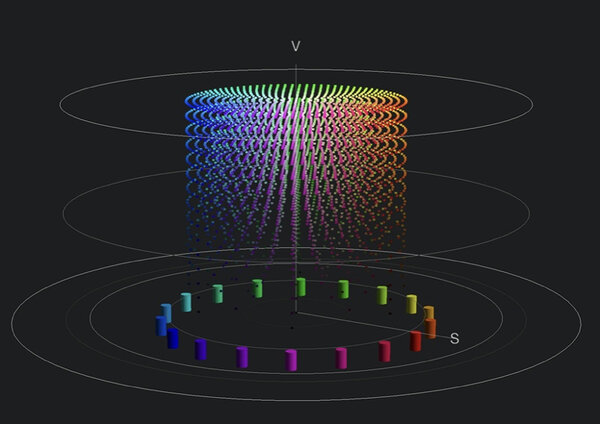

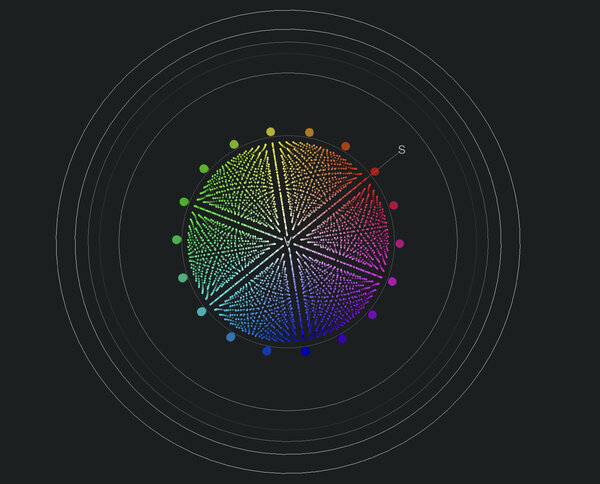

C’est une des représentations spatiales que tu peux faire mais tu peux aussi en faire d’autres, par exemple toutes les mêmes couleurs peuvent être représentées sous la forme d’un volume HSV.

C’est un cylindre. Là, les couleurs sont réparties comme des rayons d’une roue de vélo. Tu as les teintes reparties autour de la périphérie du cylindre, la saturation c’est l’éloignement au centre et la densité c’est la hauteur du cylindre. Toujours est-il que toutes les transformations esthétiques qu’on peut faire, quand tu les visualises sous forme de volume, ça devient plus parlant parce que ça devient des compressions et des rétractations du volume de couleurs.

La Fig. 4, c’est une mire avec un look Baselight film C101. Quand tu regardes le cube dans le look film en Fig. 5, tu vois qu’au lieu d’aller vers tous les coins il y a des coins qui sont enfoncés.

Caroline : Il y a des coins qui sont complètement noirs.

Martin : Il n’y a plus de cyans. La saturation maximum du cyan n’existe pas dans ce look film. Ça ne veut pas dire que ces pixels ont disparu, ça veut dire qu’ils ont été déplacés, qu’il y a des compressions et des dilatations du volume couleur.

Caroline : Et la matrice 3x3 là dedans ?

Martin : Une matrice 3x3, c’est donc des coefficients de multiplication des primaires rouge verte et bleue et quand tu appliques une matrice 3x3 sur un cube droit, tu vas effectivement changer le volume de forme. Ensuite la matrice 3x3 ne permet pas de faire toutes les transformations que tu souhaites parce que comme ça concerne toutes les valeurs, ce que tu peux faire avec une matrice 3x3, c’est que tu vas coucher des faces du cube, tu peux les incliner mais si tu veux les arrondir, par exemple, tu ne peux pas le faire avec des matrices 3x3.

Quand tu regardes la même représentation de la même LUT film, tu vois qu’il y a un enfoncement des saturations dans le magenta-bleu et il y a ce qui en fait est une séparation des verts : les verts verts n’existent pas, il n’y a que des verts jaunes ou des verts cyans. Il y a une espèce d’écartement de cet endroit-là .

Le bon endroit pour penser des modifications très générales de la couleur, c’est-à-dire un look à l’endroit d’une émulsion, par exemple, c’est le volume. Cette interprétation du réel, on ne veut pas que ce soit le carré parfait que je t’ai montré et qui est l’interprétation fidèle. On veut une déformation de ce volume.

Caroline : La Sony donc, ce qu’elle restitue, c’est le cube entier ?

Martin : Il y a deux choses : en analyse, oui, elle essaye d’avoir tout, et ensuite il y a le look Rec 709 Sony, il faudrait voir ce qu’il produit mais par exemple le look Rec 709 Arri, qui est un tout petit peu interprété, il ne fait pas le cube entier.

Le but de tous ces looks Rec 709, c’est qu’ils rendent toutes les saturations, mais Arri, par exemple, ils ont fait une petite compression des verts pour les avoir moins forts, Sony je ne suis pas sûr qu’ils l’aient fait.

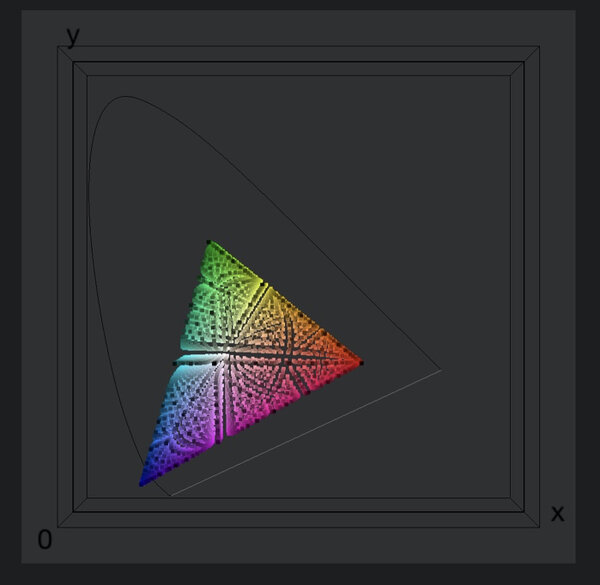

Il y a une autre manière de se représenter la couleur :

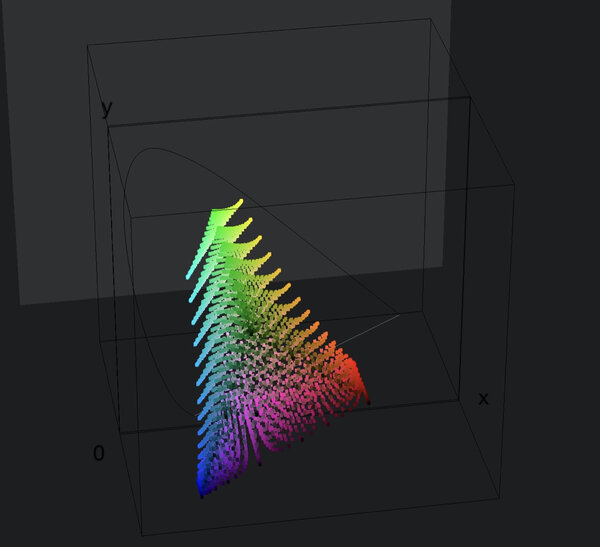

Ça c’est un volume aussi, c’est juste qu’on le regarde toujours en deux dimensions. Le volume, il est comme en Fig. 7.

Donc tout est toujours en volume puisque la couleur, ce n’est pas juste la couleur à un seul état des densités, c’est à toutes les densités, il y a donc a toujours une troisième dimension.

Si on te demande ce qui serait beau à faire, clairement dans ce modèle-là, qui ne ressemble à rien, c’est compliqué de formuler des hypothèses esthétiques. Tandis que sur le cylindre HSV (Fig. 2 et 3), ça devient possible. Tu peux dire que tu aimerais les rouges un peu moins saturés, donc rentrer le cylindre à l’endroit des rouges par exemple.

Entre les différents espaces couleur de caméra, donc les différents Gamuts, ce qui compte, c’est à quel point un espace couleur peut restituer de la saturation, soit leur largeur : à quel point le vert, le rouge et le bleu seront éloignés du centre. Là-dessus, il n’y a pas tellement de mystère, on veut capter beaucoup de saturation parce qu’on veut être sûr que tout rentre dans la caméra, en revanche on veut en restituer peu parce qu’en fait on n’en a pas besoin de beaucoup.

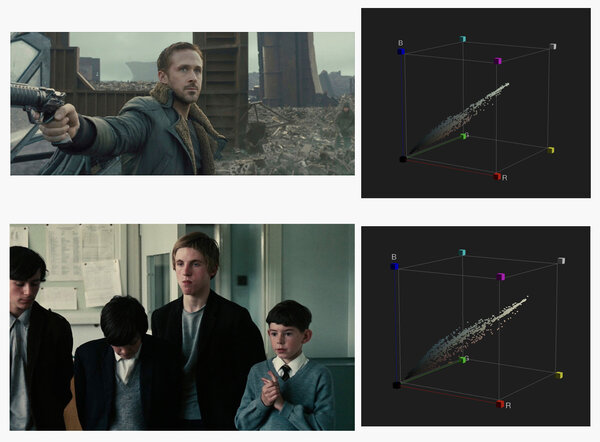

Image de Kes de KL et de Blade Runner avec leurs volumes couleurs idem conversation 1

Caroline : Et là, on en revient au concept de palette.

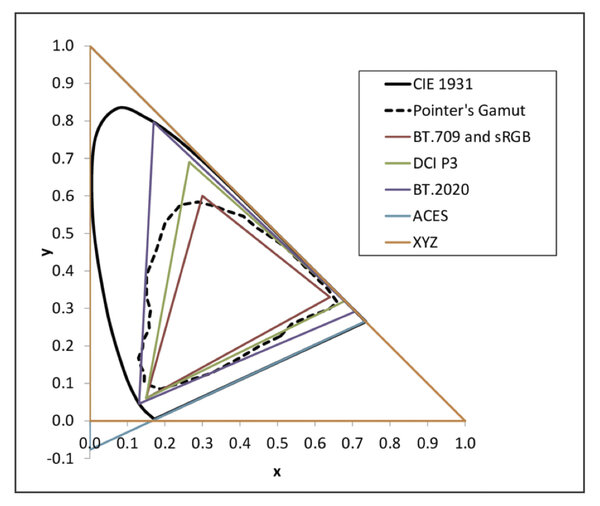

Martin : Oui et il y a un truc qui est assez parlant sur quelles sont les saturations utiles, qui s’appelle le Gamut de Pointer (Michael R. Pointer) qui regroupe les couleurs du visible. Un Gamut, c’est un espace couleur. Dans les années 1980, Pointer a tout mesuré afin de savoir ce qui existe comme couleurs réfléchies sur terre, c’est-à-dire des couleurs éclairées par le soleil. Donc ça ne comprend pas le laser, les gilets fluos, les choses artificielles... mais par contre toutes les saturations que tu peux retrouver, les pigments les plus rouges... et ça fait un Gamut comme ça :

On se rend compte qu’il n’est pas immense. Il ne représente que les couleurs vraiment utiles pour l’homme. Un laser vert va être hors de ce Gamut, mais on s’en fiche. Les espaces couleurs immenses, comme le RED Wide Gamut avec sa primaire verte qui est très loin, au fond ça sert à ce que la caméra ne clippe pas mais restituer ce type de sursaturation n’a aucun intérêt.

Caroline : D’accord, Pointer, c’est ce qui existe mais n’est ce pas encore trop large par rapport à ce qu’on cherche sur un film précis... Ce qu’on veut nous, nous qui faisons de la cinématographie, c’est produire une image qui se constitue en souvenir donc en fait une image simple.

Martin : Le Gamut de Pointer ne te renseigne effectivement pas là-dessus. Déjà ça te renseigne sur le fait que de manière générale, il n’y a pas besoin de restituer les très hautes saturations car ce n’est pas naturel pour l’œil humain. Donc déjà on va pouvoir les ramener vers le centre.

Caroline : Si on revient à la palette de Blade Runner.

Martin : Dans la palette de Blade Runner, il y a aussi des questions de direction artistiques qui ne sont pas encore des questions d’étalonnage. Il y a des situations monochromes avant que l’étalonnage ne le soit. C’est difficile de parler de la palette de Blade Runner parce qu’il y a deux gestes artistiques forts, c’est un film, très bien postproduit, ça il n’y a pas de doute, qui a en amont une direction artistique éblouissante et en fait une synthèse incroyable...

Il y a une partie qui sont les peaux dont en réalité on a pas tellement le choix parce que les peaux optimales ne sont pas n’importe où. Le fait de les obtenir va nous coûter un peu dans les couleurs proches.

Caroline : Quand tu dis « elle va nous coûter », c’est-à-dire que si on veut de la séparation de couleur dans les peaux, forcément on va devoir compresser ailleurs mais où ?

Martin : Par exemple, on ne peut pas dire qu’on veut des très belles peaux mais par contre on ne veut aucune saturation des rouges. Parce que si tu coupes le rouge...

Ensuite il y a aussi que si tu veux des peaux un peu chaudes (ce que Kodak estimait comme étant l’attente générale et ils n’ont pas tort parce que ça a été démontré par plusieurs études) en réalité, tu es obligée d’envoyer le jaune un peu vers le rouge, ton jaune primaire va être plutôt être un jaune orangé...

Caroline : Oui plutôt vers le rouge que vers le vert.

Martin : Dès que tu envoies le jaune vers le vert, tu as les peaux qui vont vers le vert et ça ne va à personne. On en a parlé la dernière fois.

Caroline : C’est drôle déja en argentique, je demandais un point de jaune tout le temps partout. C’était mon rapport, je pense, à la quadrichromie. Je voyais bien que le jaune était éliminé.

Martin : Sauf que ceci étant, mettant un point de jaune dans la chaîne argentique, tu joues de toutes façons dans le ring construit par Kodak. Tu joues avec des limites qui sont toujours là.

Si tu regardes la Fig. 4 représentant la même mire avec un look Baselight, et que l’on te demande s’il y a toutes les couleurs, on dirait plutôt oui. C’est seulement en comparant à la Fig. 9 qu’on peut constater que l’on a enlevé énormément de saturation dans le magenta, il est devenu beaucoup plus bleu, le jaune est plus orangé, etc. Mais en fait ces couleurs-là, tu n’en as pas fondamentalement besoin. Là, c’est une énorme réduction de palette, c’est la compression que tu as vu tout à l’heure en Fig. 5 sur laquelle il n’y avait plus les coins.

Mais en fait quand on ne te propose que ça, tu dis « bien sûr qu’il y a toutes les couleurs », je vois du jaune, je vois du vert, je vois du rouge, je vois du bleu...

Réfléchir à une palette de look, c’est réfléchir à un traitement couleur par couleur : où je veux que soient mes verts, est-ce que je veux beaucoup ou peu de séparation, quelle couleur de vert, des verts gras ou des verts secs, etc.

Rapidement, une fois que tu t’occupes du bleu du ciel, des verts et des peaux, éventuellement de la saturation maximum dans le rouge, tu t’es déjà occupé de beaucoup de choses parce que tu as contaminé le cyan, etc. Ensuite il y a globalement la saturation, il y a des questions sur comment réagissent les hautes lumières et comment réagissent les basses et puis il y a des questions annexes exemple, qui tiennent plus aux problématiques propre à chaque film, à ces motifs.

Caroline : Donc au départ du travail sur un projet, on doit établir une série de questionnements qui, étape par étape, priorité par priorité, va définir une palette, jusqu’à modeler le volume couleurs de ce projet.

Fin du second entretien.

- Lire ou relire la première partie de cette conversation entre Caroline Champetier et Martin Roux.

- Lire le point de vue de Pierre Cottereau sur le sujet.

- Lire celui de Céline Bozon, AFC.

- Lire le point de vue de Thibault Carterot, gérant de M141.

En vignette de cet article, illustration extraite du traité des couleurs Farbenkugel (Sphère des couleurs), de Philipp Otto Runge, Hamburg, 1810.

En

En Fr

Fr